Optimiser la Gestion Stratégique des Données avec l'Automatisation

Pour comprendre au mieux les besoins de leurs clients et y répondre, les entreprises doivent être en mesure d'accéder aux informations, de les regrouper et de les analyser rapidement et avec précision.

"Jamais auparavant des entreprises n'ont pu quintupler leur capitalisation boursière [aussi rapidement], et c'est parce que ce sont des entreprises qui sont bâties sur des données."

-Ray Wang, fondateur et analyste, Constellation Research

Les données définissent l'ère de la personnalisation

L'avenir des entreprises est une route pavée de données. Pour comprendre au mieux les besoins de leurs clients et y répondre, les entreprises doivent être en mesure d'accéder aux informations, de les regrouper et de les analyser rapidement et avec précision.

Considérez l'impact de la Tech sur la façon dont les données sont partagées par les consommateurs et utilisées par les organisations.

Les grandes entreprises comme Amazon, Apple, Meta, Google et Netflix ont changé la façon dont les gens s'attendent à interagir avec les entreprises avec lesquelles ils interagissent. Les consommateurs sont devenus moins réticents pour partager les données privées - de leurs habitudes d'achat à leurs anniversaires en passant par les étapes importantes de leur vie - en échange d'expériences meilleures, plus rapides et plus personnalisées.

Le résultat de tout ce partage de données est stupéfiant. En 2020, chaque personne a généré 1,7 mégaoctet de données par seconde. Et en 2025, le monde aura produit 181 zettaoctets de données.

Cette évolution vers la personnalisation ne montre aucun signe de ralentissement, et les organisations doivent pouvoir accéder à des ensembles de données solides et validées afin d'analyser et de comprendre en profondeur les comportements et les préférences de leurs clients.

À l'exception des plus grandes banques, qui ont un meilleur accès au financement et aux ressources nécessaires pour innover rapidement, le secteur des services financiers dans son ensemble a été relativement lent à s'adapter à cette tendance à la personnalisation. La plupart des entreprises, y compris les banques de détail et les assurances ont du mal à accéder aux données transactionnelles et comportementales les plus pertinentes sur leurs clients ou leurs membres et à les regrouper.

Mais l'accès à ces données est devenu essentiel pour permettre aux organisations de services financiers de prendre des décisions stratégiques intelligentes sur les meilleurs investissements et sur la manière de se développer le plus efficacement possible pour l'avenir, mais également de retenir tout simplement leur clientèle.

C'est là que l'automatisation et l'orchestration des processus IT peuvent aider les entreprises à accompagner l'évolution des attentes des clients.

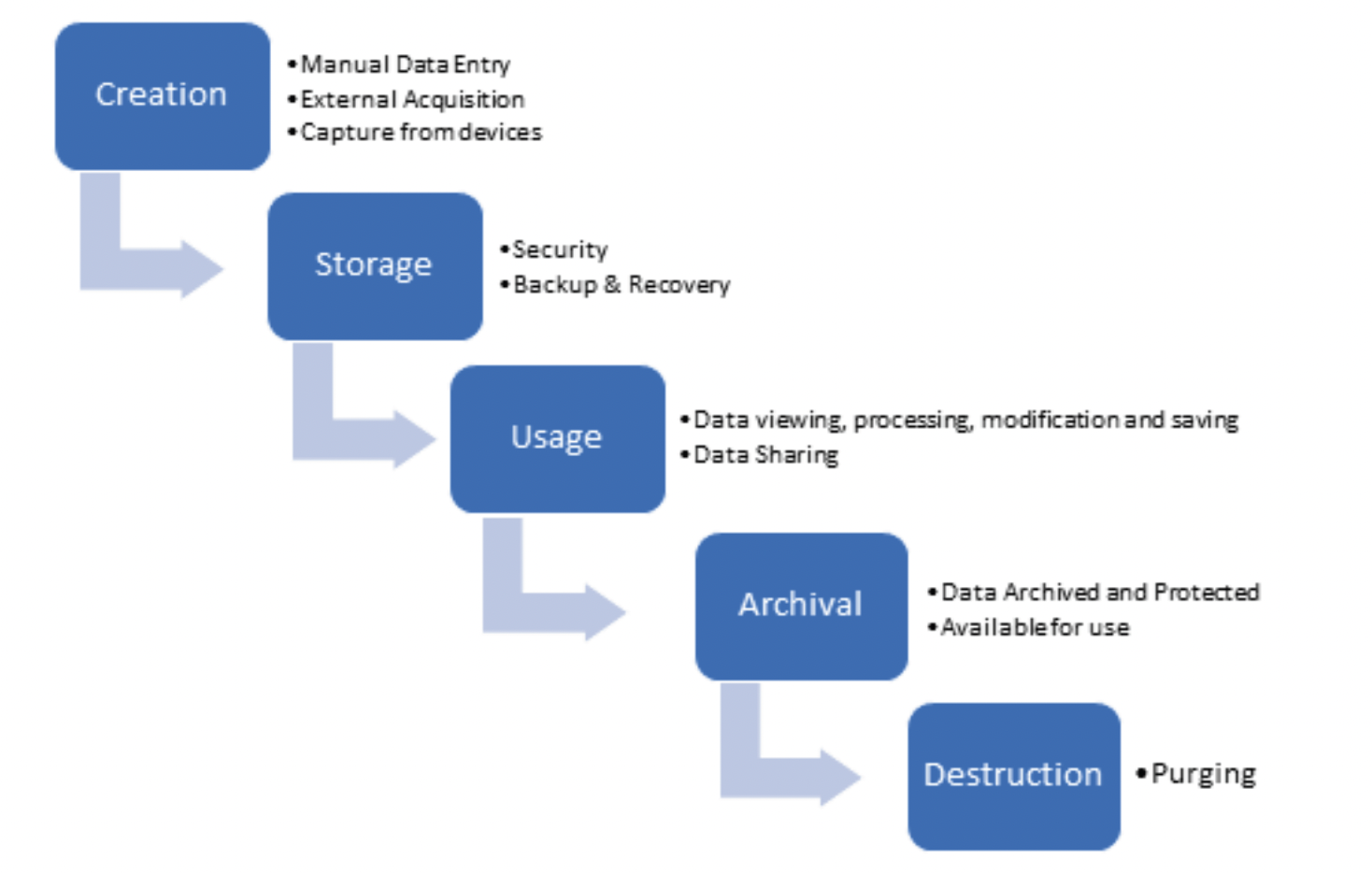

Processus clés du cycle de vie des données

Le cycle de vie des données est le parcours des données depuis leur création et leur utilisation jusqu'à leur archivage et, finalement, leur suppression.

En ce qui concerne les éléments clés de l'accès, de la transformation, de l'agrégation et de l'analyse des données, il est utile de se pencher sur la définition des technologies et processus connexes :

- Les systèmes de production : Le système de production (ou système transactionnel) est l'endroit où naissent les données. Dans le contexte des institutions financières, il s'agit souvent du système de traitement de base, mais il peut également s'agir de systèmes de création de prêts à la consommation ou de prêts hypothécaires. D'autres systèmes transactionnels qui hébergent les données des clients ou des membres comprennent les réseaux de paiement, les bases de données comptables, les systèmes de traitement des relevés, les systèmes de courtage, etc.

- Data warehouse : Dans sa définition la plus simple, un data warehouse est l'endroit où une organisation stocke ses données commerciales à des fins d'interrogation, de recherche et d'analyse. Le data warehouse est distinct des systèmes de production, qui compilent et stockent les données pour les utiliser dans le traitement des transactions. Les bases de données de production ne sont pas optimisées pour l'interrogation, la recherche et l’analyse métier et ne sont pas adaptées pour ce type de besoins. Le data warehouse est conçu pour être un entrepôt de données provenant des sites transactionnels pour une analyse optimale, sans risque de perturber, d'impacter ou d'interrompre la production. Les data warehouses permettent également d'agréger des données provenant de plusieurs systèmes et applications distincts à des fins de stockage et d'analyse.

- Les Data lakes sont apparus ces dernières années comme une alternative ou un complément aux data warehouse. Les data lakes sont de très grands référentiels de stockage qui peuvent contenir une quantité massive de données structurées et non structurées. L'une des principales différences entre un data lake et un data warehouse est que dans un data lake, les données sont généralement conservées sous leur forme brute, native, et ne sont transformées que lorsqu'elles sont prêtes à être utilisées pour l'analyse. En revanche, un data warehouse extrait, nettoie et transforme les données des systèmes transactionnels pour les utiliser spécifiquement à des fins d'analyse.

- Extraction, transformation et chargement (ETL) : l'ETL est un processus en trois étapes permettant d'extraire des données des systèmes de production et de les charger dans un entrepôt de données dans un format commun à des fins d'analyse. Les processus ETL permettent aux utilisateurs d'extraire les données demandées des systèmes de production, de les transformer - en normalisant et en standardisant les données dans un format commun qui peut être lu et analysé - puis de les charger dans le data warehouse pour analyse.

- Business Intelligence (BI) : La Business Intelligence est un terme général qui désigne la capacité d'analyser les données, de produire des rapports et d'en tirer des enseignements. Alors que l'entrepôt de données est le référentiel des informations brutes, la Business Intelligence fait référence à la sortie, c'est-à-dire à la connaissance approfondie des données dont les dirigeants et les métiers ont besoin pour prendre des décisions stratégiques éclairées.

À cette fin, les solutions de BI comprennent souvent des outils de visualisation et de reporting tels que des tableaux de bord et des rapports personnalisés qui permettent aux dirigeants et à la direction d'assimiler et de prendre des décisions sur la base des informations fournies.

Les entreprises font face à de multiples défis avec les données

La mauvaise qualité des données coûte à l'économie américaine plus de 3 000 milliards de dollars par an. C'est pourquoi 95 % des entreprises citent leur incapacité à gérer les données non structurées comme un problème business. La mauvaise gestion des données coûte cher aux organisations dans un large éventail de secteurs, et ce problème ne fait que s'aggraver.

Par le passé, les organisations avaient du mal à accéder aux données hébergées dans leurs systèmes de production. Avant l'avènement d'outils de visualisation faciles à utiliser, elles devaient embaucher des spécialistes des données et des développeurs experts pour rédiger des requêtes personnalisées.

Outre le temps et les coûts associés développer et exécuter ces requêtes personnalisées, celles-ci étaient conçues pour accéder au système transactionnel, ce qui pouvait potentiellement ralentir ou interrompre les processus métier critiques. Cela conduisait à des temps d'arrêt imprévus, voire à des pannes critiques qui affectaient les applications métier et donc les activités commerciales avec les clients. A l’heure de la digitalisation, ces impacts ne sont plus tolérables avec l’intégration directe des applications sur les sites de E-commerce et sont immédiatement coûteuses en image et en revenu.

Aujourd'hui, même avec l'introduction des data warehouses qui peuvent stocker les données séparément des systèmes de production, les organisations doivent extraire des informations de différentes sources de bases de données. Le plus souvent, ces systèmes ne communiquent pas - ils utilisent des langages, des formats de fichiers et des conventions de nommage différents. Il en résulte des transferts de fichiers plus lents, une plus grande incidence des erreurs humaines et une frustration accrue. En moyenne, les clients stockent jusqu’à 7 fois les mêmes données dans un format différent, cela a un coût important de stockage, rend très lent et coûteux leur gestion et analyse.

En outre, le respect des opérations bien orchestrées lors de l'extraction des données de ces différents systèmes est essentiel pour garantir l'exactitude et la qualité des données. Il est essentiel de transférer les données vers le data warehouse au bon moment et de la bonne manière, à une fréquence régulière et soutenue. C'est une exigence opérationnelle qui est difficilement gérable par des processus manuels. Si les fichiers ne sont pas livrés au bon moment et dans le bon ordre, cela peut entraîner des interruptions des processus qui ont un impact négatif immédiat sur les rapports internes et externes, voire sur le service à la clientèle. Ce sont les processus critiques de synchronisation des données qui se doivent à minima être journaliers ou réalisés plusieurs fois par jour. Leurs disfonctionnements conduisent à ne pas produire les données (Ex: mise à jour des prix ou des stocks) ou pire, produire des données fausses.

Bien entendu, les données brutes sont souvent entachées d'erreurs de saisie, qu'il s'agisse de chiffres transposés, de noms et d'adresses mal orthographiés ou de champs manquants ou dupliqués. Le traitement des exceptions est une étape importante du processus d'extraction et de transformation des données, et il est difficile à gérer manuellement. C’est le processus de gestion de qualité de la donnée initial qui est également critique pour assurer leur cycle de vie.

Enfin, lorsqu'il s'agit de gestion de données en provenance de plusieurs sources internes et même parfois externes, avec une logique complexe, les processus d’intégration avec les principaux outils de BI et d'entrepôt de données devient essentielle.

Un autre facteur est venu compliquer la gestion des données. Au-delà des volumes en croissante augmentation, la gestion devient de plus en plus contrainte avec le digital qui impose des traitements qui doivent se rapprocher du temps réel et intégrer des données externes pour valoriser davantage l’analyse et l’expérience client. Ex: données météo dans le retail, indices et analyses financières pour les banques, données d’analyses marchés, etc... et enfin l’ajout de données non structurées telles que des vidéos et images.

Le dernier facteur qui complique la problématique, c’est l ‘apparition des plateformes applicatives en remplacement des ERP ou les données étaient finalement assez statiques et structurées. Les plateformes sont capables de mettre en ligne des modèles de business très pertinents et évolutifs basés sur la donnée et la création de nouveau micro-services en mode agile. La donnée est cruciale et c’est souvent à la mise en place que l’on découvre la dette technique importante de la gestion de données. C’est un des principaux obstacles à la digitalisation des entreprises et donc leurs performances.

BPI France a souligné “ Les entreprises qui ne sont pas capable de bien gérer leurs données auront une valorisation nettement inférieure, verront leur valeur se déprécier et finiront par disparaitre”

L'automatisation des processus IT permet d'accéder à une connaissance approfondie des données et de fiabiliser leur qualité au quotidien

Il existe des solutions conçues pour optimiser l'efficacité des processus d'extraction, de stockage et d'analyse des données. L'automatisation et l'orchestration des processus permettent aux entreprises de collecter des informations stratégiques et très fines sur les données, tout en libérant des ressources pour se concentrer sur l'innovation et la croissance stratégique.

La valeur que l'automatisation apporte à l'entreposage de données, à l'ETL et à la veille stratégique est basée sur l'orchestration. Les outils ETL dédiés sont très efficaces pour normaliser les données et les transformer des systèmes transactionnels en systèmes optimisés pour les requêtes et les analyses. Très souvent, cependant, ils ne sont pas efficaces pour coordonner tous les mouvements de données qui doivent avoir lieu. Ils ne savant pas également assister les équipes opérationnelles en cas de problème. Une équipe va passer plusieurs heures à établir un plan de reprise en cas d’incident qui va être réalisé un moins d’une heure.

L'automatisation peut ne pas être nécessaire pour les systèmes simples, où il suffit de déplacer les données d'un système transactionnel vers un data warehouse. Cependant, pour les organisations complexes qui extraient des données de plusieurs systèmes sans lien entre eux, les outils d'automatisation modernes apportent une valeur ajoutée considérable. Plus précisément, ils garantissent que le mouvement des données se fait au moment voulu et dans le bon ordre pour assurer le bon fonctionnement de l’entreprise au quotidien.

“Pour exemple, un système non automatisé et non monitoré a laissé plusieurs heures vendre des produits non disponibles à des clients et au mauvais prix. Cela a provoqué une chute des ventes immédiate et des clients qui ont changé de plateforme, une dégradation d’image qui prendra des semaines ou des mois à restaurer. Sans parler des erreurs de facturation produites..."

Cet exemple est très intéressant car il illustre l’impact en cascade sur plusieurs étapes qui à priori sont très dissociées. Mais le fait de vendre en ligne implique des séquencements applicatifs quasiment immédiats. A partir d’une erreur de mise à jour de prix ou de quantité disponible, cela va impacter la facturation qui est immédiate et donc enchainer des erreurs jusqu’à la supply chain qui ne va pas commander des produits car ils sont supposés disponibles... C’est un changement profond et majeur de gestion des processus qu’il faut revoir pour éviter ces défaillances qui passent de minimes à majeures en quelques minutes s'ils ne sont pas automatisés.

L'automatisation peut également aider lorsque les choses tournent invariablement mal. Par exemple, si une institution doit extraire des données de huit sources différentes vers le data warehouse dans un ordre spécifique, l'automatisation peut être conçue pour garantir que les étapes se déroulent dans l'ordre. Si, par hypothèse, une étape particulière prend trop de temps, l'automatisation peut remédier à un problème potentiel grâce à la gestion des erreurs et des exceptions. L'automatisation peut également être programmée pour inverser les processus en cas d'échec d'une étape, afin de garantir que les rapports contiennent toujours des données complètes et exactes à 100 %.

" Nous avons vu des travaux échouer parce que le nom du fichier n'était pas le bon ", explique Kathy Aspenson, directrice des opérations à la Westby Co-op Credit Union. "La fonction de surveillance de SMA attend et recherche un fichier. Si le fichier n'est pas trouvé, il envoie un e-mail pour alerter le personnel. Cette fonctionnalité permet de traiter nos dossiers en temps voulu."

Avec l'automatisation des processus IT, les entreprises peuvent utiliser les données pour :

- Mettre à disposition les données et les rapports toujours à l’heure

- Assurer la qualité des données à 100%

- Diminuer sensiblement le coût de gestion des données en éliminant les tâches manuelles

- Optimiser la performance de l’accès aux données

- Utiliser leurs données pour proposer des offres et un marketing personnalisés afin d'augmenter les revenus.

- Offrir une expérience utilisateur plus personnalisée à leurs clients

- Offrir un portail de ventes 24/24 sans ajout de personnel et fiable à 100%

- Digitaliser ses métiers avec la qualité requise au meilleur cout

Le savez-vous ? “90% des projets digitaux échouent la première fois car la gestion des données et l’environnement opérationnel est mal organisé et souvent peu automatisé” Source Gartner

Grâce à une intégration propre et simplifiée avec des plateformes et des solutions tierces, l'automatisation des processus IT réduit la nécessité de maintenir des ensembles de compétences spécialisées au sein du personnel, tout en aidant les entreprises à conserver leurs meilleurs talents en élevant leurs responsabilités au-delà de la gestion de tâches techniques banales.

L'automatisation permet également de faire le lien entre des environnements technologiques hybrides très variés, tout en renforçant la conformité et la sécurité et en améliorant la planification et en accélérant les tests applicatifs et de continuité des activités.

Le monde d’aujourd'hui, et celui de demain pour la majorité des entreprises et organisations doit se structurer autour des données présentes dans l’entreprise et y associer des données externes pour créer de la valeur client pour rester rentables et efficaces. Les organisations sont prêtes à suivre si on les accompagne une voie de rationalisation des processus, de recherche de la qualité constante érigée à l’échelle de l’entreprise et des solutions IT adaptées. Après la logistique, les néo-banques, le transport urbain,... c’est le début de la plateformisation massive du système d’information

L'automatisation est utile à chaque étape du cycle de vie des données

Les solutions modernes d'automatisation et d'orchestration de processus IT comme la plateforme OpCon sont conçues pour rationaliser les processus à chaque étape du cycle de vie des données. Il s'agit notamment de :

- Entreposage des données

- Gestion et programmation des mouvements de fichiers et des chargements de données

- Extraction, transfert et chargement (ETL)

- Distribution des rapports

- Collecte automatisée répétitive des données métier (RPA)

- Rapports métiers, ventes, ...

- Rapports financiers

Une plateforme telle qu’OpCon embarque des intégrations et des API pour les principales solutions de gestion de données et reporting notamment Talend, SAP BI, SAP BODS, Informatica, ODI, Qlick view, Cognos, Datastage, Microsoft Azure Data Lake, S3, SFTP, …..

LE PLUS

Plus récemment, la plateforme OpCon s’est enrichie d’une fonction RPA (Robotic Process Automation). Cette brique permet d’intégrer les données externes, pas forcément structurées provenant d’emails par exemple et de les mettre dans une source structurée en validant la qualité dès le départ. Ce type d’automatisation est actuellement très populaire car non intrusive, on ne touche pas aux applicatifs en place, et très rapide à mettre en œuvre par des personnes sans connaissances techniques particulières, avec un ROI très rapide.

Pour exemple, elle permet :

- Entreposage des données

- Gestion et programmation des mouvements de fichiers et des chargements de données

- Extraction, transfert et chargement (ETL)

- Distribution des rapports

A Savoir : Très souvent, si on interroge les équipes, elles se disent bien automatisées et il est vrai que des efforts substantiels ont été réalisés avec l’adoption des principes DevOps par exemple. Si on inventorie l’outillage existant, il apparait qu’ils ont plusieurs outils parfois dont les plages de recouvrement peuvent être importantes. Et c’est là qu’il faut de nouveau repenser l’automatisation. Elle a été pensée par silos, les administrateurs ont leur outil d’automatisation, les développeurs les leurs, les opérationnels les leurs et ainsi de suite… Cela induit plusieurs problèmes majeurs.

- Il subsiste des zones de rupture des process car un process ne connait pas ces silos et s’en affranchi pour son fonctionnement, ils restent très fragiles

- Chaque département maintien à son rythme ses process et les évolutions sont chaotiques, le contraire de l’agilité recherchée.

- En cas d’erreur ou d’interruption du process, plusieurs compétences sont nécessaires pour le redémarrage, peu de gens ayant une connaissance générale.

- Les process deviennent très complexes alors qu’ils doivent se simplifier pour être plus efficaces. Chacun essayant de l’optimiser dans son coin, les limites d’optimisation sont vite atteintes en mode silo.

Un des challenges à venir va être de mettre en place une gouvernance de l’automatisation d’un SI de bout en bout. L’automatisation doit être intégrée dès le départ dans les projets. Si on ne peut pas automatiser un process, c’est qu’il est mal conçu ou éventuellement vous n’avez pas les bons outils, donc retour à la case design et conception ou changer d’outillage.

Un des maux des deux décennies au sein du département informatique a été de concevoir des applications et des interfaces sans se soucier du côté opérationnel. La dette technique apparait au grand jour avec la digitalisation pour qui chaque silo devient un obstacle couteux à franchir et à gérer.

La plateforme d’automatisation va s’imposer dans les 3 à 5 ans qui viennent et sera le vecteur de rationalisation des coûts et des ressources nécessaires pour faire face aux coûts de modernisation indispensables.

Une automatisation qui VALORISE LES DONNEES et démontre toute son efficacité

OpCon est conçu pour rationaliser les processus de collecte de données et d'ETL de manière répétable afin de permettre l'utilisation efficace des data warehouses, des data lakes, de l'IA, de la business intelligence et d'autres applications. Et avec le soutien des experts en automatisation de SMA, la mise en œuvre est simple avec un ROI tangible rapide.

"Avant OpCon, nous passions beaucoup de temps à gérer le transfert des données depuis et vers les sites FTP sécurisés des filiales. Nous avions deux personnes à temps plein dédié à cette tâche en raison de toutes les interventions manuelles requises. Maintenant, OpCon gère les transferts de fichiers de manière plus sécurisée et avec un monitoring très simple et efficace. Quand un fournisseur me met en cause, je sais lui dire immédiatement si le fichier a été transféré ou pas, complet ou non et à quelle heure", déclare Pascal Cosneau, IT Operations Manager de la banque EFG.

Grâce à la plateforme d'automatisation des processus IT OpCon, nous n'avons plus besoin de recruter pour absorber les charges supplémentaires liées à la croissance interne et externe de la banque et à sécurisé davantage les données et toute la logique de transfert.

“Avant, nos processus d’intégration avec Talend étaient gérés unitairement. A chaque nouveau flux, nous devions créer une tâche différente” cite le responsable des process BI de la société Manitou. Actuellement avec l’automatisation multi instance de la plateforme OpCon, nous ajoutons simplement un nouvel Item qui est le nom du processus dans une liste. OpCon génère automatiquement le nouveau processus avec les variables correspondantes. C’est très rapide à ajouter par toute l’équipe, fiable et très visuel en termes de monitoring, chaque process étant distinct finalement. En cas d’erreur, nous sommes capables d’identifier immédiatement celui en erreur et le relancer directement grâce au plan prédictif multi-jours. Il n’y plus de tests techniques à faire car la logique reste inchangée. C’est un système très agile et évolutif sans limites.

Le service fiscal des revenus d'un état utilise la plateforme OpCon pour automatiser la gestion de ses données à travers plusieurs outils et langages de programmation.

"Cet outil est tout simplement génial. Il peut faire tout ce que nous voulons faire. S'ils le supprimaient, je quitterais mon travail", déclare un responsable. "Il nous permet de tout synchroniser de manière transparente, d'Unix à Unisys, de Linux à SAP, etc. L'intervention humaine n'est pratiquement plus nécessaire. Cela a vraiment permis de réduire les erreurs."

Un autre manager a déclaré : "Aucun des autres produits que nous avons étudiés ne pouvait adresser tous les environnements et applications que nous avons comme OpCon."

Un intégrateur de systèmes dans une banque ajoute : "Cela réduit le temps nécessaire pour déplacer les fichiers individuellement. Il a réduit de 98 % ce que nous aurions fait manuellement à un moment donné et de manière très sécurisée maintenant."

Et un responsable des opérations informatiques d'une entreprise financière de plusieurs milliers d’employés déclare : "OpCon a réduit nos temps de traitement des données de 25 à 30 %, selon les technologies. Les temps inter traitement des processus pour sécuriser les chevauchements ont été simplement supprimé, cela a fait gagner des heures précieuses."

Un DSI d’un groupe de négoce majeur a confié "Quand j’ai investi dans cet outil, j’ai pu consolider par étapes les exploitations de 10 SI à 6 SI puis à un centre pour la France sans impact sur les métiers. Cela a été une pierre angulaire du schéma directeur qui a relégué la gestion opérationnelle sensible car très dépendante des humains en un « non-sujet ». Tous les investissements réalisés ont été bonifiés dans la plateforme que nous faisons évoluer régulièrement. Nous sommes à un niveau d’industrialisation que nous ne pensions pas atteindre initialement et cela continue de progresser avec les fonctionnalités nouvelles apportées régulièrement, notamment avec OpCon Deploy."

A savoir : De manière générale une plateforme apporte simplification et gain de temps importants dans la gestion quotidienne, mais également un ROI non tangible mais important en matière de sécurité et d’agilité extrême.

Un autre facteur intéressant, peu communiqué par les clients, elle joue un rôle dans la gestion des évolutions des ressources humaines. Elle permet des montées en compétences des personnels existant, nul besoin de chercher à remplacer ses personnels ou recruter des experts introuvables actuellement. Les personnels se sentent valorisés et sont réellement impliqués car l’extension des process qui ouvre naturellement une fenêtre sur les métiers qu’ils appréhendent mieux par le simple fait d’automatiser un process de manière plus approfondie et va nécessiter d’engager les échanges avec un métier ou un responsable de domaine.

Mise en place d’une plateforme d’automatisation « CLOUD READY » sans délais

Afin d'accéder à l'ensemble des données clients et transactionnelles dont elles disposent et de les analyser, les entreprises d'aujourd'hui doivent déployer une plateforme d'automatisation et d'orchestration des tâches et processus iT qui va bien au-delà des logiciels traditionnels de planification des tâches et autres ordonnanceurs dont le ROI plafonne, voir décroit quand on commence à utiliser le Cloud. Les Plateformes sont conçues pour fonctionner de manière directe et sécurisée via API avec les systèmes transactionnels, les entrepôts de données, les plateformes de veille stratégique et les outils ETL, afin d'extraire et de fournir des données significatives dans un format et une structure permettant d'obtenir des informations fines pour délivrer plus de valeurs aux clients et porter la croissance via le numérique.

Les entreprises ont également besoin d'une solution simple à mettre en œuvre, qui offre une orchestration complète, peut être déployée rapidement et offre une fiabilité de service 24 heures sur 24, 7 jours sur 7, disponible en mode Saas/Cloud ou “On Premise” grâce au support d'une équipe de service spécialisée, orientée vers le client et qui comprend parfaitement les différents secteurs métier, Banque, Assurances, retail, Logistique, Services...

La plateforme OpCon peut être disponible et prête à l’emploi sous 24H dans le Cloud. Un premier lot d’automatisation est mis en production sous 20 jours ouvrables, nous le garantissons

Il est important de mettre en place la solution de manière adéquate dès le départ afin de pouvoir assurer qu'elle fonctionne sans problème et soit évolutive sans dégrader les services pour fournir aux outils de veille stratégique un flux continu de données dont vous avez besoin pour servir vos clients et gérer votre entreprise.

L'automatisation et l'orchestration des processus IT des données repose sur une plateforme conçue pour aider les entreprises à accéder aux données dont elles disposent déjà et à les analyser. C’est une première phase qui est cruciale pour valoriser les données et pouvoir les enrichir avec des sources externes de toute nature, contenant des données structurées ou non structurées. (Achat de données externes, données RPA, collecte de données plus poussées par les métiers, banque d’images, vidéos...)

La seconde phase dans la gestion de données va créer un gisement de valeur pour l’entreprise pour entrer dans l’ère de la personnalisation extrême qui va faire augmenter les ventes, et surtout la marge par la vente de services additionnels numériques impossible par les canaux conventionnels.

ET enfin accéder à la troisième phase de gestion des données à très haute valeur ajoutée, celle qui va vous démarquer définitivement de votre concurrence directe, voir plus si vous êtes dans un marché à évolution rapide.

Il va s’agir d’enrichir les données dites « connues » à celles provenant du Machine learning pour accompagner le client dans un contexte momentané pendant le cycle de vente. Il existe bien sur d’autres sous-jacents que nous ne détaillerons pas ici.

Pour exemple et illustrer, il existait des centrales de réservation de taxi avant la plateforme Uber. Uber a réussi à combiner le contexte immédiat de la flotte automobile au contexte de trafic local où se situe le client et celui du parcours pour prédire avec précision le temps de prise en charge et le temps d’atteinte de la destination au final qui permet de valider immédiatement l’acte. Cette information ne repose que sur de la data et le contexte est de plus en plus calibré avec du ML. Exemple de l’intégration de zone de manifestations ou de panne majeure sur un train.

A savoir : A l’heure de la massification du cloud dans les architectures informatiques, les plateformes sont devenues majoritaires dans la modernisation du socle applicatif. Elles s’avèrent rapides à mettre en place, hautement interopérables et très sécurisées avec des couts maitrisés. Les métiers les adoptent rapidement car elles parlent le même langage. La plateforme d’automatisation n’échappe pas à cette règle. Les coûts de fonctionnement d’une plateforme versus une application n tiers vont du double au triple. Le computing nécessaire est divisé par deux à minima pour gérer le même volume de transactions.

À l'ère de la personnalisation de l’expérience utilisateur, l'automatisation des données est l'un des outils les plus importants et les plus percutants à votre disposition.

Pour planifier une démonstration de la puissance de la plateforme d'automatisation OpCon et commencer à recueillir des réponses à vos questions essentielles, contactez les experts en automatisation SMA.